Mixture of Experts (Uzmanların Karışımı)

Makine öğrenimi ve derin öğrenme alanlarında, karmaşık görevleri daha verimli ve etkili şekilde çözmek için çeşitli yöntemler geliştirilmiştir. Bu yöntemlerden biri de Mixture of Experts (MoE) yani Uzmanların Karışımı modelidir. MoE, büyük ve karmaşık veri setleriyle başa çıkmak ve farklı alt-problemleri çözmek için uzmanlaşmış “alt-modelleri” bir araya getirerek çalışır.

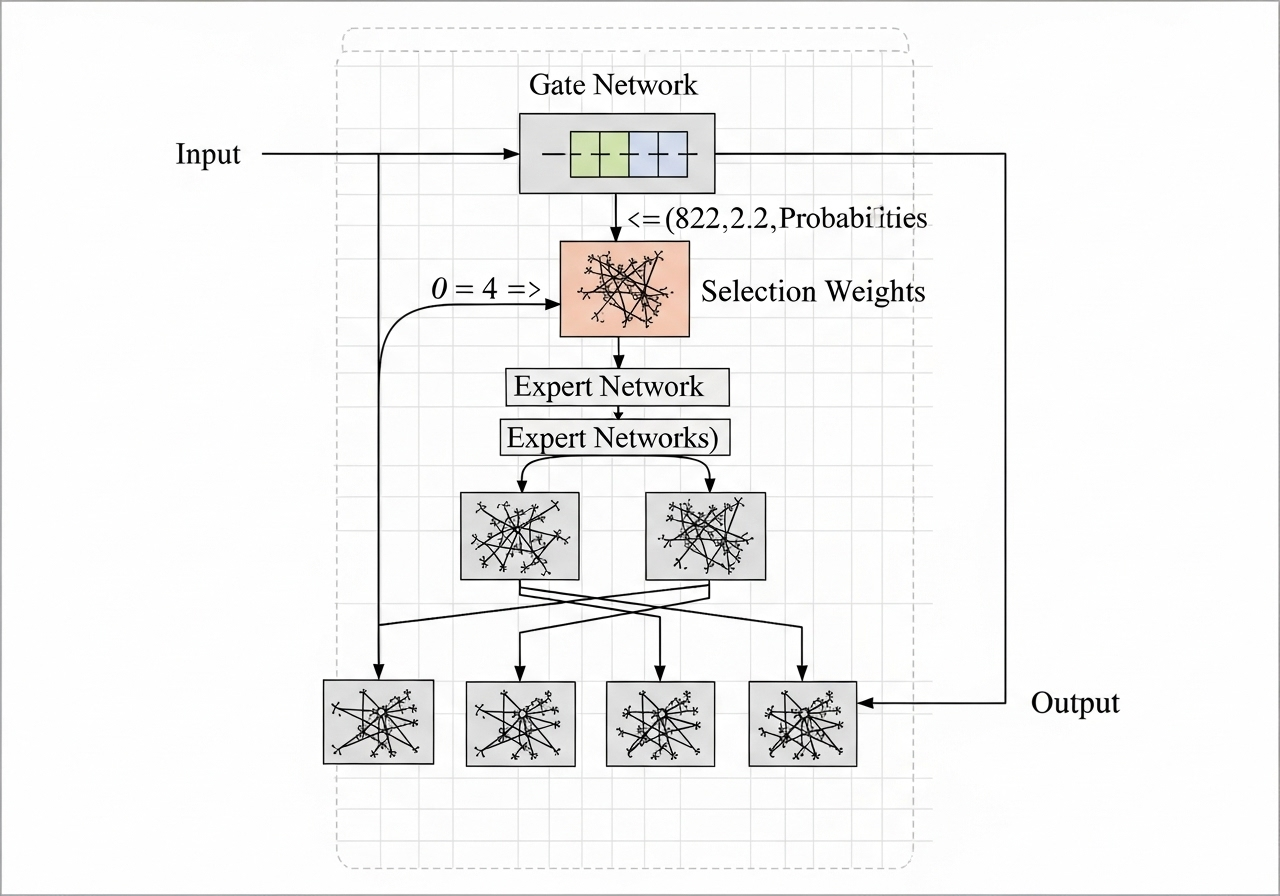

Mixture of Experts modeli, temel olarak birkaç farklı uzman model (expert) ve bu uzmanlar arasında seçim yapan bir gate (kapı) mekanizmasından oluşur. Her uzman, belirli bir alt problemi çözmekte daha iyidir. Gate fonksiyonu ise gelen girdiye göre hangi uzmanın çıktısının daha çok dikkate alınacağını belirler. Böylece, model gelen veriye göre dinamik olarak en uygun uzman(lar)ı seçer veya çıktılarının bir birleşimini kullanır.

Neden Mixture of Experts?

- Ölçeklenebilirlik: Büyük veri setlerinde ve kompleks problemlerde, tek bir modelin her şeyi iyi yapması zordur. MoE, farklı uzmanları devreye alarak, her birinin kendi güçlü yanlarından faydalanır.

- Verimlilik: Her veri örneği için sadece birkaç uzman aktif olduğu için, model gereksiz hesaplamalardan kaçınır ve kaynak kullanımını azaltır.

- Uyarlanabilirlik: Farklı görevler, verinin farklı kısımlarını gerektirebilir. MoE bu konuda oldukça esnektir.

Uygulama Alanları

- Doğal Dil İşleme (NLP): Büyük dil modellerinde (örneğin Google’ın GShard, Switch Transformer gibi modelleri) milyarlarca parametreyi verimli şekilde eğitmek için kullanılır.

- Görüntü İşleme: Farklı uzmanların, görüntünün çeşitli özelliklerine odaklandığı bilgisayarla görme görevlerinde uygulanır.

- Çok Görevli Öğrenme: Birden fazla görevin aynı anda öğrenilmesi gereken durumlarda, her görev için farklı uzmanlar kullanılabilir.

Zorluklar ve Gelişmeler

MoE’nin en büyük zorluklarından biri, gate mekanizmasının doğru ve dengeli şekilde uzmanları seçebilmesini sağlamaktır. Ayrıca, modelin dağıtık ortamlarda eğitiminde “aşırı yüklenmiş” (overloaded) uzmanlar veya hiç kullanılmayan uzmanlar gibi dengesizlikler ortaya çıkabilir. Son yıllarda, bu sorunları çözmek için çeşitli iyileştirmeler ve yeni MoE mimarileri geliştirilmiştir.

Sonuç

Mixture of Experts yaklaşımı, ölçeklenebilir, esnek ve verimli modeller oluşturmak için güçlü bir yöntemdir. Özellikle büyük veri ve büyük model gerektiren günümüz yapay zeka uygulamalarında giderek daha fazla kullanılmaktadır.